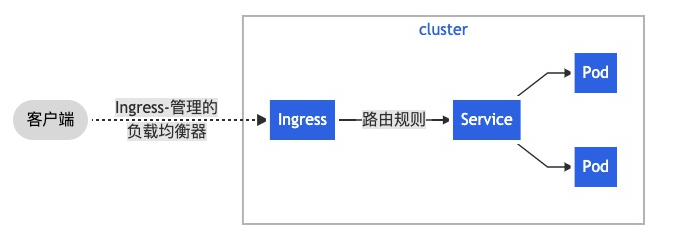

Ingress-nginx 是 Kubernetes(简称 K8s)生态体系中专门用于管理集群外部访问的核心流量治理工具,其底层基于成熟的 Nginx 服务器实现。它的核心价值在于为 K8s 集群提供了统一的外部流量入口,允许用户通过声明式的方式定义路由规则,将集群外部的 HTTP/HTTPS 流量精准引导至集群内部对应的 Service 资源,进而分发到后端 Pod。同时,Ingress-nginx 还原生支持 TLS 证书配置(实现 HTTPS 加密)、虚拟主机(基于域名区分多服务)、流量负载均衡、路径重写、请求限流等丰富功能,是 K8s 集群中实现服务对外暴露、流量分发与安全管控的关键组件,广泛应用于微服务架构下的多服务统一入口管理场景。

一、工作原理

Ingress-nginx 的核心工作机制依赖于「Ingress 资源」与「Ingress Controller」两大核心组件的协同工作,其完整工作流程通过 Ingress Controller 与 K8s 集群的 API Server 持续交互实现,具体逻辑与细节如下:

动态感知规则变化:Ingress Controller 作为独立的运行组件(通常以 Deployment 模式部署在 K8s 集群中),会通过 K8s 的 Client-go 库与 API Server 建立长连接,持续监听集群中「Ingress 资源」的变化(包括新增、修改、删除等操作)。这种长连接监听模式能确保 Ingress Controller 第一时间感知到规则变更,避免了轮询带来的延迟问题;

解析 Ingress 规则:当 Ingress Controller 感知到 Ingress 资源变化后,会从 API Server 中拉取最新的 Ingress 资源配置,对其进行解析。Ingress 资源的核心是路由规则,通常包含「域名(host)」「路径(path)」「后端服务(backend.service)」「端口(backend.servicePort)」等关键信息,解析后可明确“某个域名的某个路径请求,应转发至集群内哪个 Service 的哪个端口”;

生成 Nginx 配置:Ingress Controller 内置了标准化的 Nginx 配置模板,解析完 Ingress 规则后,会将规则中的域名、路径、后端服务等信息填充到模板中,动态生成一段符合 Nginx 语法规范的配置片段(例如 location 块配置、upstream 后端服务配置等)。这里需要注意的是,生成的配置会自动关联 K8s 集群内 Service 对应的 Endpoints(即后端 Pod 的 IP 列表),确保流量能精准触达后端实例;

配置生效与更新:Ingress Controller 会将生成的 Nginx 配置动态写入自身运行的 Pod 内部(因为 Ingress Controller Pod 中内置了 Nginx 服务进程),具体是覆盖 Nginx 的主配置文件(通常为 /etc/nginx/nginx.conf)或对应的配置片段文件。配置写入完成后,Ingress Controller 会执行 Nginx 的平滑重载命令(nginx -s reload),该命令能在不中断现有连接的前提下使新配置生效,确保业务流量的连续性。

通过上述“监听-解析-生成-重载”的自动化流程,Ingress-nginx 实现了域名分配、流量精准转发及配置动态更新的核心效果。整个过程无需运维人员手动登录 Nginx 服务器修改配置,极大降低了运维成本,同时能快速适配业务服务的新增、迁移或扩容需求,保证了流量治理的灵活性与高效性。

Ingress-nginx 工作原理示意图如下:

二、使用 Ingress 的核心优势

集中化端口管理,提升安全性与可维护性

核心价值:通过统一入口集中管理端口,兼顾安全性与可维护性,解决多服务暴露的混乱问题。

具体优势与说明:

- 统一流量入口:所有外部 HTTP/HTTPS 请求均通过 Ingress Controller 的统一 IP:PORT(默认 80/443 端口)进入集群,无需为每个服务单独暴露端口;

- 提升安全性:减少集群对外暴露的端口数量,缩小攻击面,降低未授权访问风险;

- 简化运维管理:路由规则与端口资源集中在 Ingress 中配置,便于统一查看、修改和审计;

- 适配多服务场景:支持通过不同域名区分多服务(如 user.example.com 对应用户服务、order.example.com 对应订单服务),实现多服务共享同一外部入口。

规避 NodePort 模式的管理痛点

核心价值:对比 NodePort 模式,解决其端口分散、管理复杂、访问不友好的核心痛点。

NodePort 模式的核心痛点:

- 端口资源分散:每个服务占用独立高位端口(30000-32767),服务增多后难以记忆和管理;

- 存在冲突风险:多服务误配置相同 NodePort 会导致服务启动失败;

- 访问体验差:需通过「节点 IP+高位端口」访问,不支持域名,不符合用户习惯。

Ingress 对应的解决方案:

- 集中端口管理:共享 80/443 标准端口,无需占用大量分散高位端口;

- 避免冲突问题:路由规则通过域名/路径区分服务,不存在端口冲突;

- 友好访问方式:支持域名访问(如 example.com),符合常规使用习惯,无需记忆复杂端口。